En este último bimestre del curso de "temas de Física" se está abarcando en su gran mayoría temas englobados en la física moderna, entre los que podemos encontrar:

- cuantos

- teoría de la relatividad

- predecibilidad

- caos

- núcleo

- radiactividad

- fusión

- fisión

A continuación se describirán cada uno de los puntos anteriormente mencionados. Cabe recalcar que la "física moderna" NO es difícil de entender. siempre y cuando pongamos dedicación, empeño e interés. Espero y les sea de ayuda esta información ....

1.Cuanto de energía.

En física, el término cuanto o cuantio (del latín Quantum, plural Quanta, que representa una cantidad de algo) denotaba en la física cuántica primitiva tanto el valor mínimo que puede tomar una determinada magnitud en un sistema físico, como la mínima variación posible de este parámetro al pasar de un estado discreto a otro. Se hablaba de que una determinada magnitud estaba cuantizada según el valor de cuanto. Es decir, cuanto es una proporción hecha por la magnitud dada.

Un ejemplo del modo en que algunas cantidades relevantes de un sistema físico están cuantizadas se encuentra en el caso de la carga eléctrica de un cuerpo, que sólo puede tomar un valor que sea un múltiplo entero de la carga del electrón. En la moderna teoría cuántica aunque se sigue hablando de cuantización el término cuanto ha caído en desuso. El hecho de que las magnitudes estén cuantizadas se considera ahora un hecho secundario y menos definitorio de las caracterísitcas esenciales de la teoría.

En informática, un cuanto de tiempo es un pequeño intervalo de tiempo que se asigna a un proceso para que ejecute sus instrucciones. El cuanto es determinado por el planificador de procesos utilizando algún algoritmo de planificación.

EXPLICACIÓN CIENTÍFICA DEL CONCEPTO DEL CUANTO DE ENERGÍA: Durante más de dos siglos la física newtoniana resultó válida para describir todos los fenómenos concernientes a materia y energía. Después, en el siglo XIX, la teoría electromagnética reveló que la energía podía existir con cierta independencia de la materia, en forma de radiaciones de muy diferentes longitudes de onda y frecuencias. Al mismo tiempo, el estudio de la termodinámica abordó problemas suscitados por la energía calorífica y su distribución en sistemas como los gases, cuyas partículas resultaban demasiado pequeñas para ser medidas u observadas.

Era imposible —y afortunadamente innecesario— predecir el comportamiento de cada molécula o de cada átomo, pero las leyes estadísticas de la probabilidad podían aplicarse a grandes conjuntos de partículas, dentro de una reducida muestra o sistema.

Era imposible —y afortunadamente innecesario— predecir el comportamiento de cada molécula o de cada átomo, pero las leyes estadísticas de la probabilidad podían aplicarse a grandes conjuntos de partículas, dentro de una reducida muestra o sistema.

En un gas, a determinada temperatura, unas moléculas se mueven muy lentamente y otras con gran celeridad: sin embargo, la energía media de todas las moléculas en movimiento depende exclusivamente de la temperatura y de la presión a que dicho gas esté sometido si el volumen es constante. Max Planck (a la izquierda) fue uno de los muchos científicos que trataron de aplicar los principios de la termodinámica a las radiaciones. Él, científico alemán (1858-1947) fue el responsable de introducir una innovación que cambiaría para siempre el rumbo de la Física.

Probando distintas funciones y haciendo infinidad de cálculos, Planck había encontrado (sin deducirla de principios de la Física) una fórmula que describía muy bien los espectros experimentales de los cuerpos negros.

Pero encontrar la forma funcional de una relación no significa explicar por qué resulta así. Esta fórmula se resistía a ser deducida de los principios clásicos. Entonces Planck, sin demasiado convencimiento, se vio obligado a introducir un postulado que no tenía, en principio, ninguna justificación, pero que le permitía predecir perfectamente los espectros de radiación que la naturaleza mostraba. Era el siguiente:

"Los osciladores microscópicos responsables de la emisión electromagnética no pueden emitir o absorber cualquier valor de energía. Si el oscilador tiene frecuencia y, sólo emitirá o absorberá múltiplos enteros del cuanto de energía E = h . v (donde h es la constante de Planck).

El valor de h es muy pequeño, 6,63. 1O–34 J . s, y resultó ser una constante universal, fundamental dentro de la teoría cuántica."

Comportamiento encontrado por Planck para la emisión de un cuerpo negro P(µ,T) es la potencia

emitida y µ es la longitud de onda

emitida y µ es la longitud de onda

Para fines del siglo XIX, se sabía que la radiación de un cuerpo negro se debía a las oscilaciones de las partículas cargadas de la superficie de estos cuerpos. Sin embargo, a partir del electromagnetismo clásico era imposible deducir los espectros y las leyes experimentales de Stefan-Boltzmann y de Wien. La Física clásica había llegado a un límite que no podría superar.

Que la energía estuviera cuantízada, que no fuera continua sino discreta, era tan absurdo como suponer que cuando una piedra cae libremente no puede pasar por todas las alturas posibles, sino que va saltando, de una posición a otra mas distante sin pasar por las intermedias.

En un principio este resultado no causó gran conmoción en la comunidad científica, pues se lo consideró como un artilugio con poco asidero real.

Según la teoría clásica de las ondas electromagnéticas, éstas transportan energía en forma continua y no en paquetes discretos o cuantos. Vemos que la luz de una vela llena una habitación con un flujo constante de energía. Sin embargo, la cuantización implicaría una emisión espasmódica de la luz, como si la vela parpadeara, encendiéndose y apagándose intermitentemente (que es en realidad lo que ocurre en el nivel microscópico!). El mismo Planck no podía creer que esto fuera así. Pasarían algunos años hasta que el cuanto de energía fuera aceptado como una realidad.

Calculemos el valor del cuanto de energía para una onda electromagnética de la región visible de frecuencia 5. 1O14 Hz (amarillo):

E = h . v 6,63. 1O–34 J. s . 5. 1014 Hz = 3,3. 10–19 J.

Este valor de energía es diminuto. La energía que libera una pequeña luciérnaga, por ejemplo, contiene miles de millones de cuantos. Esto hace que la cuantización de la energía de las ondas electromagnéticas no tenga efectos macroscópicos, pero sí tiene peso cuando se estudian fenómenos a escala atómica.

HACIA LA MECÁNICA CUÁNTICA

Estas ideas de Planck y Bohr se van a difundir, a ampliar y después a revolucionar con la llegada de una nueva Mecánica, la Mecánica Cuántica, que deriva directamente de ellas. Gracias a esta revolución conceptual se va a tener que renunciar a cualquier descripción determinista de la realidad para acogerse a una descripción en términos de probabilidad.

Estas ideas de Planck y Bohr se van a difundir, a ampliar y después a revolucionar con la llegada de una nueva Mecánica, la Mecánica Cuántica, que deriva directamente de ellas. Gracias a esta revolución conceptual se va a tener que renunciar a cualquier descripción determinista de la realidad para acogerse a una descripción en términos de probabilidad.

Así es como se llegó a la conclusión de que no se puede conocer al mismo tiempo la posición y la velocidad de una partícula. Se va a demostrar también que cualquier medida perturba el fenómeno que quiere estudiar. Es el famoso principio de incertidumbre deHeisenberg.

En resumidas cuentas, con la Mecánica cuántica se entra en un nuevo mundo palpitante, misterioso y extraño que se ha explorado sobre bases matemáticas sólidas entre los años 1925-1930, bajo el impulso de sabios cuyos nombres son ya legendarios, como el austríaco Erwin Schródinger, el alemán Werner Heisenberg, el suizoalemán Wolfgang Pauli, el inglés de Cambridge Paul Dirac, todo bajo el impulso constante de Niels Bohr, y a pesar del escepticismo de Albert Einstein. Pero ésa es otra historia, casi una epopeya.

Einstein había visto antes que nadie todas las implicaciones de la Mecánica cuántica. Pero por razones filosóficas, y casi teológicas, no podía aceptarla. Es el famoso ¡«Dios no juega a los dados»!

Sobre lo que nosotros queremos insistir aquí es que muchos fenómenos pueden quedar sencillamente explicados —o al menos claramente expuestos— partiendo del átomo de Bohr ligeramente modificado. No cabe duda de que se trata de una primera aproximación, que no corresponde a la realidad tal como la concebimos hoy en día, pero tiene la ventaja de evitar el despliegue matemático y la complejidad intelectual inherentes a la Mecánica cuántica (que, si se quiere captar su espíritu, necesita larguísimos cálculos, ya que el mundo de lo infinitamente pequeño obedece a reglas específicas muy diferentes de las que gobiernan nuestra experiencia cotidiana).

LOS NIVELES DE ENERGÍA

En cada átomo, en cada molécula, existen niveles de energía en los que pueden «situarse» los electrones. Esos niveles se corresponden con los cuanta y por lo tanto están, como hemos dicho, separados por intervalos vacíos, lo mismo que los peldaños de una escalera. Los electrones no pueden hallarse más que en esos niveles, lo mismo que nuestros pies no se pueden colocar más que en los peldaños de la escalera.

En cada átomo, en cada molécula, existen niveles de energía en los que pueden «situarse» los electrones. Esos niveles se corresponden con los cuanta y por lo tanto están, como hemos dicho, separados por intervalos vacíos, lo mismo que los peldaños de una escalera. Los electrones no pueden hallarse más que en esos niveles, lo mismo que nuestros pies no se pueden colocar más que en los peldaños de la escalera.

Naturalmente, esto es la representación del átomo bajo el punto de vista de la energía. Bajo el punto de vista del espacio, el electrón se mueve sin cesar, gira en torno al núcleo, pero en una órbita impuesta por los niveles de energía autorizados.

Esos niveles de energía no pueden «contener» más que un número finito de electrones. Por ejemplo, el primer nivel de energía de un átomo, el primer peldaño, no puede llevar más que dos electrones, el segundo es un peldaño doble que, en total, no puede contener más que 8 electrones (2 + 6), etcétera.

¿Cómo puede situarse un electrón en esta escalera?

Se llenan los peldaños comenzando por abajo, según el principio de energía mínima, pasando poco a poco de uno a otro. Así es como, en cada átomo estable, hay niveles de energía llenos. El último nivel lo está más o menos completamente.

Se llenan los peldaños comenzando por abajo, según el principio de energía mínima, pasando poco a poco de uno a otro. Así es como, en cada átomo estable, hay niveles de energía llenos. El último nivel lo está más o menos completamente.

Pero por encima del último nivel lleno hay otros niveles (otros peldaños de la escalera) totalmente vacíos. A estos niveles se les llama niveles «excitados».

¿Puede un electrón abandonar un nivel de energía que ocupa normalmente (y que se llama el nivel estable) para pasar a un nivel de energía excitado? Pues sí, pero para eso hay que proporcionarle la energía suficiente para que logre saltar de un nivel a otro. Pero cuidado, es menester que la energía que se le comunica sea exactamente la que corresponde a la diferencia de energía que existe entre los dos peldaños, lo que se llama el «cuantum» justo de energía.

¿Y esos electrones excitados situados en órbitas libres van a permanecer allí?

Respuesta: sí, pero no por mucho tiempo. Los niveles de excitación no son los niveles de equilibrio para los electrones. Así pues, éstos van a tener tendencia a caer los niveles de energía habituales (hogar, dulce hogar) y, por lo tanto, a volver a ellos.

Respuesta: sí, pero no por mucho tiempo. Los niveles de excitación no son los niveles de equilibrio para los electrones. Así pues, éstos van a tener tendencia a caer los niveles de energía habituales (hogar, dulce hogar) y, por lo tanto, a volver a ellos.

Cuando lo hacen, la energía tiene que conservarse. La caída de un electrón de un nivel elevado hacia uno más bajo va a ir acompañada de una liberación de energía, por ejemplo mediante la emisión de una luz cuya longitud de onda (el color) será exactamente igual a la de la luz que ha excitado el átomo.

2.Teoría de la relatividad

Para continuar el homenaje a Albert

Einstein, vamos a repasar ahora brevemente la Relatividad General en un texto

que sirve como introducción para aquellos no iniciados en esta rama de la

física. La teoría general de la relatividad de

Albert Einstein es uno de los logros más imponentes de la física del siglo

veinte. Publicada en 1916, explica lo que percibimos como «fuerza de

gravedad». De

hecho, esta fuerza surge de la curvatura del espacio y del tiempo. Einstein propuso que los objetos

como el Sol y la Tierra variaban la geometría del espacio.

En presencia de materia y energía,

el espacio se puede deformar y estirar, formando cordilleras,

montañas y valles que causan que los cuerpos se muevan por estas

"rutas" curvas.

DURANTE más de dos siglos, la mecánica de

Newton dominó completamente en la física: el Universo

entero parecía comportarse tal como lo predecían las ecuaciones de la física

newtoniana y la comprensión de la naturaleza se había reducido a un problema de

técnica matemática. Pero

a principios del siglo XX empezaron a surgir evidencias de que la física

clásica, así como todos los conceptos relacionados con ella, no describe

adecuadamente a los fenómenos que suceden a la escala de los átomos o a

velocidades comparables a la de la luz.

La mecánica clásica constituye una

excelente aproximación a la realidad, dentro de ciertos límites.

Sin embargo en la escala microscópica, los

fenómenos físicos sólo pueden estudiarse por medio de la mecánica

cuántica. Y cuando se tratan velocidades muy altas,

cercanas a la luminosa, se debe recurrir a la teoría

de la relatividad. La primera revolución científica del

siglo XX se produjo cuando Albert Einstein formuló, en 1905, la teoría de la relatividad

especial.

A continuación describiremos los rasgos

esenciales de esta teoría.

Para estudiar o describir un fenómeno

físico debemos recurrir necesariamente a un «sistema de referencia» con respecto al cual efectuamos mediciones. En la

práctica cotidiana el sistema de referencia que más se utiliza, es la Tierra

misma que, en general, se supone inmóvil, a pesar de que gira sobre sí misma y

alrededor del Sol, recorriendo el espacio cósmico a una velocidad de 30 km/seg.

En cambio, para describir el movimiento

de los planetas, es más conveniente utilizar al Sol como punto de referencia,

o, más precisamente, como centro de un sistema de referencia donde este astro

está fijo. Pero ni el Sol, ni las estrellas vecinas a él, se

encuentran realmente fijos: el Sol se halla en las regiones externas de una

galaxia que rota dando una vuelta completa en millones de años. A su vez, esta

galaxia se mueve con respecto a otras galaxias, etcétera.

En la práctica afortunadamente, no es

necesario tomar en cuenta todos estos movimientos porque las leyes de la física

son las mismas en cualquier sistema de referencia. Este principio fundamental se aplica aun

para sistemas de referencia terrestres: en la época de Galileo, los filósofos

discutían si una piedra, lanzada desde lo alto del mástil de un barco en

movimiento, cae verticalmente con respecto al barco o con respecto a la Tierra.

Así, todo movimiento es relativo al

sistema de referencia en el cual se observa y, las leyes de la física, no

cambian de un sistema a otro. Este hecho fundamental se conoce como principio

de relatividad de Galileo.

Sin embargo, los filósofos y los

físicos clásicos veían con desagrado —quizá con vértigo— el hecho de que no

existiera un sistema de referencia absoluto con respecto al cual definir todos los

movimientos del Universo. Estrictamente hablando, el principio de

relatividad no excluye la existencia de tal sistema absoluto, únicamente

postula que las leyes de la física son las mismas en ese y en cualquier otro

sistema.

Pero,

a mediados del siglo XIX,

surgieron las primeras dificultades de la relatividad galileana,

cuando el físico escocés James Clerk Maxwell formuló la teoría matemática de

los fenómenos eléctricos y magnéticos.Maxwell demostró que la electricidad y el

magnetismo son dos aspectos de un mismo fenómeno: el

electromagnetismo. Como una de las consecuencias más importantes

de su teoría descubrió que la luz es una vibración electromagnética que se

propaga exactamente como una onda.

Pero las ondas lo hacen en medios

materiales, por lo que los físicos del siglo pasado postularon la existencia de

un medio extremadamente sutil, el éter, que

llenaba al Universo entero, permeaba todos los cuerpos y servía de sustento a

la luz. Según esta concepción, la luz sería una vibración del éter del mismo

modo que el sonido es una vibración del aire.

De existir el éter, sería un sistema de

referencia absoluto con respecto al cual medir el movimiento de todos los

cuerpos en el Universo. Más aún, se descubrió que las ecuaciones de

Maxwell cambian de forma al pasar de un sistema de referencia a otro, lo cual

implicaría que el principio de relatividad no se aplica a los fenómenos

electromagnéticos.

Se postuló, entonces, que estas

ecuaciones sólo son válidas en el sistema de referencia del éter en reposo. Esto no es sorprendente pues la luz, fenómeno

electromagnético, se propaga con una velocidad bien definida en el éter y esta

velocidad debe ser distinta en un sistema de referencia en movimiento con

respecto al éter.

Al parecer, la teoría electromagnética de

Maxwell restituía un sistema de referencia absoluto.

La manera más evidente de confirmar las

ideas anteriores es medir la velocidad de la luz, emitida en direcciones

opuestas, en la Tierra:

la diferencia de velocidades puede llegar a

ser tan grande como 60 km/seg .

Esta velocidad es muy pequeña con respecto a

la velocidad total de la luz, que es de 300 000 km/seg,

pero, a fines del siglo pasado, los físicos experimentales Michelson y Morley

lograron construir un aparato que permitía medir diferencias aún más pequeñas

en la velocidad de un rayo luminoso.

Michelson y Morley realizaron su experimento en 1887: para

sorpresa de la comunidad científica de esa época, no detectaron ningún cambio

de la velocidad de la luz. Esta velocidad era la misma en cualquier dirección,

independientemente de cómo la Tierra se mueva con respecto al hipotético éter.

Para empezar, Einstein postuló que las

ecuaciones de Maxwell del electromagnetismo son rigurosamente válidas en cualquier sistema

de referencia. Esta condición de invariancia se cumple a condición de que

el tiempo

medido en un sistema no coincida con el medido en otro sistema.

Este hecho no había sido tomado en cuenta por

los antecesores de Einstein y, por esta razón, las ecuaciones de Maxwell

parecían violar el principio de relatividad.

Habiendo postulado que no puede haber

ningún sistema de referencia privilegiado, Einstein concluyó que el éter

simplemente no existe. Pero, entonces ¿con respecto a qué debe medirse la

velocidad de la luz? La respuesta de Einstein fue drástica:

«la velocidad de la luz es la misma en

cualquier sistema de referencia».

Después

de todo, eso es lo que indica el experimento de Michelson y Morley.

Este concepto de la invariancia de la

velocidad de la luz contradice nuestro "sentido común". Si la velocidad

de la

luz es de 300 000 km/seg,

esperaríamos que al perseguir una señal luminosa veamos que se mueve con una

velocidad menor. (Si, por ejemplo, corremos a 80 km/hora detrás de un tren que

se mueve a 100 km/hora, vemos que el tren se mueve con respecto a nosotros a 20

km/hora.)

Sin embargo, debido a la no invariancia

del tiempo, las velocidades no se adicionan o sustraen en el caso de señales

luminosas (o, en general, de partículas que se mueven casi tan rápidamente como

la luz).

Los efectos

predichos por la teoría de la relatividad son imperceptibles en nuestra vida

cotidiana y sólo se manifiestan cuando se involucran velocidades comparables a

la de la luz.

Consideremos, como ejemplo, una nave

espacial que se mueve con una velocidad muy alta: despega

de la

Tierra y regresa después de recorrer cierta distancia.

Según la relatividad, el tiempo transcurre

normalmente tanto para los que se quedaron en la Tierra como para los pasajeros

de la nave, pero esos dos tiempos no son iguales.

Al regresar a la Tierra, los tripulantes

de la nave constatarán que el viaje duró para ellos un tiempo menor que para

los que se quedaron.

Más precisamente, el tiempo medido en la

nave es más pequeño que el medido en la Tierra por un factor de acortamiento

donde v es

la velocidad de la nave y c la velocidad de la luz.

Para velocidades v del

orden de algunos metros o kilómetros por segundo, como las que ocurren

comúnmente en nuestras experiencias diarias, el factor de acortamiento es tan

cercano al valor 1 que es imposible detectar el efecto relativista del cambio

de tiempo. Si la nave espacial viaja a unos 10 000

km/hora, la diferencia entre los tiempos medidos será apenas una diez

millonésima de segundo por cada hora transcurrida (lo cual, incidentalmente, se

ha podido confirmar con la tecnología moderna).

Pero, en el otro extremo, si la nave

viaja a una velocidad muy cercana a la de la luz, su tiempo puede ser muy corto

con respecto al transcurrido en la Tierra: por

ejemplo,

a la velocidad de 295 000 km/seg, una nave espacial tardaría unos 20 años

medidos en la Tierra para ir a la estrella Sirio y regresar; sin embargo, para

los tripulantes de la nave habrán pasado ¡sólo 3 años y medio!

La

contracción del tiempo no es el único efecto sorprendente que predice la teoría

de la relatividad. Einstein también demostró que existe una equivalencia entre

la energía y la masa, dada por la famosa fórmula

E= mc2

donde E es la energía equivalente a una

masa m de

materia.

Por ejemplo, el núcleo de un átomo de

helio está constituido por dos protones y dos neutrones, pero la masa del

núcleo de helio es un poco menor, cerca del 4%, que la masa sumada de dos

protones y dos neutrones separados (Figura

a); en

consecuencia, al unirse estas cuatro partículas pierden una fracción de masa

que se transforma en energía; éste es el principio de la fusión nuclear, que

permite brillar al Sol y a todas las estrellas (y

construir bombas atómicas).

Un núcleo de helio pesa menos que

sus componentes por separado:

dos protones y dos neutrones.

Al formarse un

núcleo de helio, la diferencia de masa se libera

en forma de energía (fusión

nuclear).

De la fórmula E

= mc² no se

deduce que cualquier masa se puede transformar en energía o viceversa; este

proceso se da sólo en condiciones muy particulares. Hemos mencionado la fusión

nuclear, pero la manera más eficiente de transformar masa en energía es por la

aniquilación

de la materia con la antimateria.

Al entrar en contacto una partícula con su correspondiente antipartícula, las dos se aniquilan

totalmente quedando sólo energía en forma de rayos gamma:

la eficiencia de este proceso de

transformación de materia en energía es del 100%.

Para aumentar la velocidad de un cuerpo,

hay que proporcionarle energía, lo cual se manifiesta como un aumento de la

masa del cuerpo. La teoría de la relatividad predice

que la energía necesaria

para que un cuerpo de masa m alcance la velocidad v es

En el límite v =

0, se recupera la fórmula E = mc² para

la energía ya existente en forma de masa.

En el otro extremo, la energía E aumenta

con la velocidad (Figura b)

y se

necesita una energía infinita para

que el cuerpo alcance la velocidad de la luz.

Es por ello que, según la teoría de la

relatividad, ningún cuerpo puede alcanzar o superar la velocidad de la luz. La

excepción es la luz misma: según la física moderna la

luz está constituida por

unas partículas llamadas fotones, la

masa de

un fotón es nula y, por ello, puede viajar a la velocidad límite c.

La energía de un cuerpo en movimiento aumenta con su velocidad.

Así, según la teoría de la relatividad,

la velocidad de la luz es una barrera fundamental de la naturaleza que no puede

ser superada. Se ha especulado sobre la existencia de

posibles partículas que se mueven más rápidamente que la luz, los

hipotéticos taquiones, pero nunca se ha encontrado alguna

evidencia de que sean reales; más aún, de existir, se producirían situaciones

contradictorias, como por ejemplo, poder regresar en el tiempo.

En la teoría de Einstein, el espacio y el

tiempo dejan de ser categorías independientes como en la física clásica, para

fundirse en un concepto unificado:

el espacio-tiempo, en el que el tiempo

aparece como una cuarta dimensión.

A primera vista, puede parecer que este

concepto desborda el marco del sentido común, pero en realidad no hay nada de

misterioso en él. Si queremos describir la posición de un objeto, necesitamos

un sistema de referencia y tres números, llamados coordenadas,

porque el espacio tiene tres dimensiones.

Por ejemplo, podemos localizar un avión si

especificamos la longitud y la latitud del lugar donde se encuentra así como su

altura sobre el nivel del mar; con estos tres datos se determina exactamente su

posición con respecto al sistema de referencia que es la Tierra

Sin embargo, como el avión se mueve,

también conviene precisar en qué momento se encontraba en la posición

indicada.

Al especificar también el tiempo, estamos

describiendo un suceso, algo

que ocurre en un lugar dado (descrito por 3 coordenadas) y en un cierto

instante (descrito por el tiempo).

Nada nos impide interpretar formalmente el

tiempo como una cuarta coordenada e introducir así, el concepto del

espacio-tiempo: un espacio de cuatro dimensiones, tres espaciales y una

temporal.

Un punto de ese espacio-tiempo será

un suceso, especificado por cuatro coordenadas.

3.Predictibilidad!

El

término predicción puede

referirse tanto a la «acción y al efecto de predecir» como

a «las palabras que manifiestan aquello que se predice»; en este sentido,

predecir algo es «anunciar por revelación, ciencia o conjetura algo que ha de

suceder»

☼Predicción científica: La

predicción constituye una de las esencias claves de la ciencia, de

una teoría científica o de un modelo científico. Así, el éxito

se mide por el éxito o acierto que tengan sus predicciones. La

predicción en el contexto científico es una declaración precisa de lo que

ocurrirá en determinadas condiciones especificadas. Se puede expresar a través

del silogismo: "Si A es cierto, entonces B también será cierto."

El método

científico concluye con la prueba de afirmaciones que son

consecuencias lógicas del corpus de las teorías científicas.

Generalmente esto se hace a través de experimentos que deben poder repetirse o

mediante estudios observacionales rigurosos.Una

teoría científica cuyas aseveraciones no son corroboradas por las

observaciones, por las pruebas o por experimentos probablemente será rechazada.

El falsacionismo de Karl

Popper considera que todas las teorías deben ser puestas en cuestión para

comprobar su rigor.

Las

teorías que generan muchas predicciones que resultan de gran valor (tanto por

su interés científico como por sus aplicaciones) se confirman o se falsean

fácilmente y, en muchos campos científicos, las más deseables son aquéllas que,

con número bajo de principios básicos, predicen un gran número de sucesos.

4. Teoría del caos.

La teoría del caos (o caología) es la

denominación popular de la rama de las matemáticas,

la física y otras ciencias

(biología,

meteorología, economía, etc.) que trata ciertos tipos de sistemas

complejos y sistemas dinámicos muy

sensibles a las variaciones en las

condiciones iniciales.

Pequeñas

variaciones en dichas condiciones iniciales pueden implicar grandes diferencias

en el comportamiento futuro, imposibilitando la predicción a largo plazo.

Esto sucede

aunque estos sistemas son en rigor determinísticos, es decir; su

comportamiento puede ser completamente determinado conociendo sus condiciones

iniciales.

Clasificación de los sistemas: Los sistemas

dinámicos se pueden clasificar básicamente en:

►Estables: cuando dos soluciones con condiciones iniciales suficientemente cercanas siguen

siendo cercanas a lo largo del tiempo. Así, un sistema estable tiende a lo

largo del tiempo a un punto, u órbita, según su dimensión (atractor o

sumidero).

►Inestables: cuando dos soluciones con condiciones iniciales diferentes acaban divergiendo

por pequeñas que sean las condiciones iniciales. Así un sistema inestable

"escapa" de los atractores.

►Caóticos,

cuando el sistema no es inestable y si bien dos soluciones se mantienen a una

distancia "finita" cercana a un atractor del

que el sistema dinámico, las soluciones se mueven en torno al atractor

de manera irregular y pasado el tiempo ambas soluciones no son cercanas, si

bien suelen ser cualitativamente similares. De esa manera, el sistema permanece

confinado en una zona de su espacio de estados, pero sin tender a un atractor

fijo.

Una

de las mayores características tanto de los sistemas inestables como los

caóticos es que tiene una gran dependencia de las condiciones iniciales (esto

diferencia a ambos tipos de los sistemas estables).De un

sistema del que se conocen sus ecuaciones de evolución

temporal características, y con unas condiciones iniciales fijas, se puede

conocer exactamente su evolución en el tiempo.

Pero

en el caso de los sistemas caóticos, una mínima diferencia en esas condiciones

hace que el sistema evolucione de manera totalmente distinta. Ejemplos de tales

sistemas incluyen el Sistema Solar, las placas tectónicas,

los fluidos en régimen turbulento y los crecimientos

de población.

Caos determinista: El caos determinista comprende

una serie de fenómenos encontrados en la teoría de sistemas

dinámicos, la teoría de ecuaciones diferenciales y la mecánica

clásica. En términos generales el caos determinista

da lugar a trayectorias asociadas a la evolución temporal de forma muy

irregular y aparentemente azarosa que sin embargo son totalmente deterministas,

a diferencia del azar genuino. La irregularidad de

las trayectorias está asociada a la imposibilidad práctica de

predecir la evolución futura del sistema, aunque esta evolución sea

totalmente determinista.

Definición de caos y atractores: No hay una definición universal

sobre el caos, pero hay tres ingredientes en los que todos los científicos

están de acuerdo:

1.Movimiento

oscilante.

Las trayectorias no

se ajustan a un punto fijo, órbita periódica u

órbita cuasiperiódica cuando .

2.Determinismo.

El sistema no es azaroso sino

determinista. El comportamiento irregular surge de la no

linealidad.

Por eso se define como determinista.

3.Sensibilidad

a las condiciones. Las trayectorias que comienzan cerca,

con el tiempo se separan exponencialmente.

Es decir, condiciones iniciales muy similares acaban dando lugar a

comportamientos diferentes pasado un tiempo suficientemente largo.

Los

sistemas caóticos típicamente se caracterizan por ser modelizables

mediante un sistema dinámico que posee un atractor.

Para definir propiamente un atractor hay

que recurrir a tecnicismos, y es difícil dar una idea intuitva

sin ellos. En una primera aproximación puede decirse que un atractor

es un conjunto en las que todas las trayectorias cercanas convergen.

Los puntos fijos y círculos

límite son un ejemplo de ello. Al igual que en la definición del caos, hay 3

ingredientes universales:

1.Cualquier

trayectoria que esté en un atractor,

estará en él para t → al infinito.

2.Atraen

un conjunto de condiciones iniciales. El conjunto lo componen las condiciones

iniciales que su trayectoria que acabe en el atractor

cuando t → al infinito.

.

3.No

existen condiciones iniciales que satisfagan las dos reglas anteriores.

Dentro de los atractores se

define como atractor

extraño o caótico cuando el atractor

exhibe dependencia sensible con las condiciones iniciales.

5. El núcleo del átomo y la radioactividad.

La mayor parte de la masa del átomo, pero no así de su volumen, radica en el núcleo. En un átomo normal, el núcleo tendrá un peso de unas cuatro mil veces el de los electrones. Consecuentemente, con una buena aproximación, se pueden ignorar los electrones cuando hablamos de la masa del átomo.

Por otra parte, el átomo es prácticamente un espacio vacío. Si el núcleo de un átomo fuese una pelota de fútbol en el suelo delante nuestro, los electrones serían como unas cuantas docenas de granos de arena esparcidos en torno a la región en que vivimos. La dimensión lineal del núcleo es normalmente 10-5 veces las dimensiones lineales de todo el átomo.

El núcleo del átomo fue descubierto en 1911 por Ernest Rutherford en Manchester, Inglaterra. Junto a sus colaboradores, tomaron una radiación denominada partículas alfa y dejaron que golpease una fina hoja de pan de oro.

Mientras la mayoría de las moléculas la cruzaron o se desviaron levemente, algunas de las partículas (una de cada mil) fueron devueltas y rebotaron hacia atrás a causa de los núcleos de los átomos de la lámina de pan de oro.

Ernest Rutherford (1871-1937)

Rutherford comparó esta prueba con el proceso de disparar una bala a una nube de vapor y descubrir que de manera ocasional podía rebotar. La única deducción que puede formularse en cualquier caso, es que en algún lugar del interior del átomo (o nube de vapor) existía un pequeño cuerpo denso que podía desviar las partículas de movimiento rápido y hacer que cambiaran de dirección. Rutherford denominó a este cuerpo pequeño y denso, el núcleo.

Rutherford era uno de esos individuos poco corrientes que hizo su más importante contribución a la ciencia tras recibir el premio Nobel. Consiguió el premio Nobel de Química en 1908 por sus estudios sobre la naturaleza de las partículas desprendidas por los materiales radiactivos, y posteriormente descubrió el núcleo.

Rutherford era uno de esos individuos poco corrientes que hizo su más importante contribución a la ciencia tras recibir el premio Nobel. Consiguió el premio Nobel de Química en 1908 por sus estudios sobre la naturaleza de las partículas desprendidas por los materiales radiactivos, y posteriormente descubrió el núcleo.

El núcleo lo forman protones y neutrones. Rutherford denomino al núcleo de hidrógeno (que es una sola partícula con carga eléctrica positiva), con el nombre de protón, que significa “el primero”. De esta manera, la carga positiva total del núcleo, consta del número de las cargas de los protones, y el número de electrones que orbitan un átomo neutro es igual al número de protones que existen en el núcleo.

El neutrón, cuyo nombre significa “el neutro”, es prácticamente igual de grande que el protón pero, como indica su nombre, no posee carga eléctrica. Se suma a la masa, pero no a la carga del núcleo y es parte importante del átomo, ya que interactúa atrayendo los protones .

La mayoría de los núcleos estables tienen de manera aproximada, un número igual de protones y neutrones. Cuando no se cumple esta regla general, como sucede con los elementos pesados, los núcleos suelen tener más neutrones que protones.

La identificación química de un átomo depende de la cantidad de protones que se hallen en su núcleo. A dicho número de protones del núcleo se le denomina número atómico, y se suele expresar comúnmente con la letra Z. El número atómico determina la naturaleza química del átomo, porque esta naturaleza química se halla determinada por los electrones más exteriores en el átomo.

De esta manera, si conocemos el número de protones en un núcleo, podemos especificar qué tipo de átomo es. Por ejemplo, si hay seis protones, el átomo es de carbono; si hay ocho, es de oxígeno, y así sucesivamente.

Los neutrones extra que existan, no cambian la naturaleza química de un átomo porque no modifican el número de electrones necesario para cancelar la carga del núcleo. Por lo tanto, es posible tener muchas clases diferentes de un tipo dado de átomo, cada una de las cuales poseerá en su centro un núcleo con idéntico número de protones, pero un número diferente de neutrones.

Dos átomos cuyos núcleos tienen el mismo número de protones pero un número distinto de neutrones se dice que son isótopos el uno del otro.

Tabla de los isótopos de los elementos ligeros. Cada línea corresponde a un elemento.

El número de cada apartado es el número total de nucleones A.

Los círculos señalan isótopos naturales.

Con mucha proximidad, se pueden observar los electrones y los núcleos como dos sistemas separados,

cada uno ocupado en sus propios asuntos e ignorando al otro. Esto significa que hay poca diferencia para

el núcleo si el átomo es por sí mismo un espacio o si sus electrones exteriores configuran parte de enlaces químicos.

El núcleo hará lo que esté haciendo en las dos situaciones.

Del mismo modo quiere decir que significa muy poca diferencia para los electrones el que existan neutrones extras

en el núcleo o no. Los diferentes isótopos de un elemento concreto se presentan igualmente adeptos a encontrar

lugares en minerales y otros materiales, y todos los isótopos de un elemento concreto aparecerán en cualquier

material que integre ese elemento.

6. Fusion y Fision nuclear.

Fusión nuclear: La fusión nuclear es una reacción nuclear en la que dos núcleos de átomos ligeros, en general el hidrógeno y sus isótopos (deuterio y tritio), se unen para formar otro núcleo más pesado. Generalmente esta unión va acompañada con la emisión de partículas (en el caso de núcleos atómicos de deuterio se emite un neutrón). Esta reacción de fusión nuclear libera o absorbe una gran cantidad de energía en forma de rayos gamma y también deenergía cinética de las partículas emitidas. Esta gran cantidad de energía permite a la materia entrar en estado de plasma.

Las reacciones de fusión nuclear pueden emitir o absorber energía. Si los núcleos que se van a fusionar tienen menor masa que el hierro se libera energía. Por el contrario, si los núcleos atómicos que se fusionan son más pesados que el hierro la reacción nuclear absorbe energía.

No confundir la fusión nuclear con la fusión del núcleo de un reactor, que se refiere a la fusión del núcleo del reactor de una central nuclear debido al sobrecalenta- miento producido por la deficiente refrigeración. Durante el accidente nuclear de Fukushima, en los medios de comunicación se utilizaba esta expresión frecuentemente.

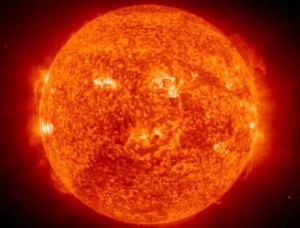

Las estrellas, incluido el Sol, experimentan constantemente reacciones de fusión nuclear. La luz y el calor que percibimos del Sol es el resultado de estas reacciones nucleares de fusión: núcleos de hidrógeno chocan entre sí, y se fusionan dando lugar a un núcleo más pesado de helio liberando una enorme cantidad de energía. La energía liberada llega a la Tierra en forma de radiación electromagnética.

Las fuerzas de gravedad en el universo generan las condiciones perfectas para la fusión nuclear.

A las reacciones de fusión nuclear también se les llama reacciones termonucleares debido a las altas temperaturas que experimentan. En el interior del Sol, la temperatura es cercana a los 15 millones de grados Celsius.

Requisitos técnicos para la fusión nuclear

Para efectuar las reacciones de fusión nuclear, se deben cumplir los siguientes requisitos:

►Conseguir una temperatura muy elevada para separar los electrones del núcleo y que éste se aproxime a otro venciendo las fuerzas de repulsión electrostáticas. La masa gaseosa compuesta por loselectrones libres y los átomos altamente ionizados se denomina plasma. ►Es necesario el confinamiento para mantener el plasma a temperatura elevada durante un mínimo de tiempo. ►Densidad del plasma suficiente para que los núcleos estén cerca unos de otros y puedan generar reacciones de fusión nuclear.

Confinamiento para la fusión nuclear: Los confinamientos convencionales que se utilizan en los reactores nucleares de fisión no son posibles debido a las altas temperaturas del plasma que deben soportar. Por este motivo, se han desarrollado dos importantes métodos de confinamiento:

- Fusión nuclear por confinamiento inercial (FCI): Consiste en crear un medio tan denso que las partículas no tengan casi ninguna posibilidad de escapar sin chocar entre sí. Una pequeña esfera compuesta por deuterio y tritio es impactada por un haz de láser, provocándose su implosión. Así, se hace cientos de veces más densa y explosiona bajo los efectos de la reacción de fusión nuclear.

- Fusión nuclear por confinamiento magnético (FCM): Las partículas eléctricamente cargadas del plasma son atrapadas en un espacio reducido por la acción de un campo magnético. El dispositivo más desarrollado tiene forma toroidal y se denomina Tokamak.

Reacciones de fusión nuclear

Los elementos atómicos empleados normalmente en las reacciones fusión nuclear son el Hidrógeno y sus isótopos: el Deuterio (D) y el Tritio (T). Las reacciones de fusión más importantes son:

D + T -> 4He + n + 17,6 MeV

Fusionando un núcleo de Deuterio con un núcleo de Tritio, se obtinene un núcleo de Helio formado por dos neutrones y dos protones, liberanto 1 neutrón y 17,6 MeV de energía.

Fusionando un núcleo de Deuterio con un núcleo de Tritio, se obtinene un núcleo de Helio formado por dos neutrones y dos protones, liberanto 1 neutrón y 17,6 MeV de energía.

D + D -> 3He + n + 3,2 MeV

Fusionando dos núcleos de Deuterio, se obtiene un núcleo de Helio formado por un neutrón y dos protones, liberando un neutrón y 3,2 MeV de energía.

Fusionando dos núcleos de Deuterio, se obtiene un núcleo de Helio formado por un neutrón y dos protones, liberando un neutrón y 3,2 MeV de energía.

D + D --> T + p + 4,03 MeV

Fusionando dos núcleos de Deuterio, se obtiene un núcleo de Tritio, un protón y 4,03 MeV de energía.

Fusionando dos núcleos de Deuterio, se obtiene un núcleo de Tritio, un protón y 4,03 MeV de energía.

Para que tengan lugar estas reacciones debe suministrarse a los núcleos la energía cinética necesaria para que se aproximen los núcleos que se van a fusionar, venciendo así las fuerzas de repulsión electrostáticas. Para ello se necesita calentar el gas hasta temperaturas muy elevadas, como las que se supone que tienen lugar en el centro de las estrellas.

El requisito de cualquier reactor de fusión nuclear es confinar dicho plasma con la temperatura y densidad lo bastante elevadas y durante el tiempo justo, a fin de permitir que ocurran suficientes reacciones de fusión nuclear, evitando que se escapen las partículas, para obtener una ganancia neta de energía. Esta ganancia energética depende de que la energía necesaria para calentar y confinar el plasma, sea menor que la energía liberada por las reacciones de fusión nuclear. En principio, por cada miligramo de deuterio-tritio se pueden obtener 335 MJ.

Combustible utilizado para las reacciones de fusión nuclear

Para las reacciones de fusión nuclear se necesitan núcleos ligeros. Básicamente se utilizan Deuterio y Tritio, que son dos isótopos del hidrógeno.

El Deuterio es un isótopo estable del hidrógeno formado por un protón y un neutrón. Su abundancia en el agua es de un átomo por cada 6.500 átomos de hidrógeno. Esto supone que en el agua de mar hay una concentración de 34 gramos de deuterio por metro cúbico de agua. El contenido energético del deuterio es tan elevado que la energía que se puede obtener del deuterio de un litro de agua de mar es equivalente a la energía que se puede obtener de 250 litros de petróleo.

Por este motivo, teniendo en cuenta, que tres cuartas partes del Planeta están cubiertas por agua, se considera la fusión nuclear cómo una fuente de energía inagotable.

El otro elemento empleado en la fusión nuclear, el Tritio, es el isótopo inestable o radiactivo del átomode hidrógeno. Está compuesto por un protón y dos neutrones y se desintegra por emisión beta con relativa rapidez. Aunque el Tritio es escaso en la naturaleza, se puede generar por reacciones de captura neutrónica con los isótopos del Litio. El Litio es un material abundante en la corteza terrestre y en el agua del mar.

Evolución histórica y proyectos futuros sobre la fusión nuclear

Los orígenes de la fusión nuclear se localizan hacia 1929 cuando Atkinson y Houtemans plantearon la posibilidad de obtener energía de las reacciones de fusión nuclear. Sin embargo, los conceptos más importantes de fusión nuclear y su aplicación real, se desarrollaron a partir de 1942 con los trabajos de H. Bethe, E. Fermi, R. Oppenheimer y E. Teller, entre otros. A través del proyecto Sherwood se llevaron a cabo los primeros avances tecnológicos, que permitieron desarrollar el concepto de confinamiento magnético, obteniéndose los primeros diseños: z-pinch, stellarator y espejos magnéticos.

En 1961, J. Nuckolls (EEUU) y N. Basov (URSS) desarrollaron una técnica mediante la cual se podrían obtener reacciones de fusión nuclear mediante altas compresiones provocadas por la cesión de energía. Se desarrollaron así programas secretos en EEUU y Rusia. Posteriormente, Francia se une a este desarrollo, también secreto. Otros países como Alemania, Japón, Italia y EEUU (Rochester) desarrollaron programas abiertos.

En 1965, Artsimovich presentó los resultados de sus investigaciones, en la “2ª Conferencia de Plasma y Fusión Controlada”, sobre el concepto TOKAMAK (Toroidal KAmera MAgnetiK).

En el concepto TOKAMAK, el campo magnético necesario para confinar el plasma es el resultado de la combinación de un campo toroidal, de un campo poloidal, ambos creados por bobinas toroidales, y de un campo vertical (creado por un transformador). El plasma actúa como secundario de un transformador por donde se induce corriente que lo calienta. Por el primario del transformador circula una intensidad de corriente variable.

En el concepto TOKAMAK, el campo magnético necesario para confinar el plasma es el resultado de la combinación de un campo toroidal, de un campo poloidal, ambos creados por bobinas toroidales, y de un campo vertical (creado por un transformador). El plasma actúa como secundario de un transformador por donde se induce corriente que lo calienta. Por el primario del transformador circula una intensidad de corriente variable.

En 1968, el Premio Nobel N. Basov, informó de la obtención de temperaturas de ignición y de la producción de neutrones en las reacciones de fusión nuclear empleando láseres. A partir de entonces, se pudo disponer de una gran cantidad de aparatos en construcción y operación bajo el concepto TOKAMAK como los siguientes: TFR (Francia), T-4 y T-11 (URSS), ALCATOR y ORMAK (EEUU). Otros como el T-10 (URSS), PLT (EEUU), DITE (GB), ASEDX (RFA) y FRASCATI (EURATOM-Italia) comenzaron a construirse.

En la década de los 70 comenzó a producirse la primera serie de publicaciones sobre FCI (Fusión nuclear por Confinamiento Inercial). En EEUU, los principales investigadores fueron Brueckner, Nuckolls, Kidder y Clark. En Rusia, Basov y su equipo consiguieron el experimento más avanzado, alcanzándose cerca de 3 millones de neutrones en la implosión de esferas de CD2.

Basados en este concepto existen y han existido multitud de instalaciones con láser que han permitido avanzadas investigaciones sobre la fusión nuclear. De ellas se pueden destacar: NOVA (40 kJ, EUUU), OMEGA (30 kJ), GEKKO-XII (10 kJ, Japón), PHEBUS (3 kJ, Francia), VOLCAN (UK), ISKRA-5 (Rusia).

A partir de estas instalaciones de láser se han desarrollado dos grandes proyectos para demostrar altas ganancias: National Ignition Facility (NIF) en EEUU y Laser Megajoule (LMJ) en Francia.

Pero el láser no es el único dispositivo capaz de producir implosiones, también se observa queelectrones y haces de iones ligeros y pesados son serios candidatos a la fusión nuclear por confinamiento inercial. Nacen así los siguientes proyectos con iones ligeros: ANGARA y PROTO (Rusia), PBFA-I y PBFA-II (EEUU).

En relación con los iones pesados, al no existir experimentos no se han podido alcanzar resultados exactos, aunque se han realizado ciertas predicciones mediante simulaciones teóricas como las realizadas en el Proyecto HIDIF (Heavy Ion Design of Ignition Facility) patrocinado por varios laboratorios e institutos europeos y por el Lawrence Berkeley Laboratory americano.

En la década de los 90, las instalaciones de tipo TOKAMAK: JET (EURATOM), TFTR (EEUU) y JT-60 (Japón), permitieron obtener cierta potencia. El primero fue el JET, que con una mezcla de D (90%) y T (10%) consiguió en 1991, una potencia de 1,7 MW. Posteriormente, en 1993, el TFTR con una mezcla de DT al 50% llegó hasta los 6 MW, alcanzándose temperaturas de 30 keV. En el calentamiento se gastaron 29 MW. En la actualidad, el TFTR está clausurado. Hasta la fecha, se han llegado a producir hasta 12 MW de potencia en reacciones de fusión nuclear controladas durante más de un segundo (JET, 1997) y existe la confianza de que con los avances tecnológicos actuales sea posible llegar al rango comercial de cientos de MW de forma mantenida.

La investigación experimental en FCM (Fusión nuclear por Confinamiento Magnético) en España ha estado concentrada en el CIEMAT (Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas), remontándose a 1983, año en el que se pone en funcionamiento la primera máquina de fusión nuclear, el Tokamak TJ-I.

Desde este instante, la investigación ha progresado de manera constante, y así, en 1994 se puso en marcha el primer dispositivo de fusión nuclear construido totalmente en España: el Stellerator TJ-I upgrade, que fue cedido en 1999 a la Universidad de Kiel al entrar en operación el TJ-II.

El TJ-II supuso un gran salto científico con respecto a los experimentos anteriores considerándose uno de los tres stellerators más avanzados del mundo junto con el alemán Wendelstein 7-AS del Instituto Max Planck en Munich y el japonés LHD de la Universidad de Nagoya.

El proyecto de fusión nuclear por confinamiento magnético: el ITER

El proyecto más avanzado en Fusión nuclear por Confinamiento Magnético es el ITER (International Thermonuclear Experimental Reactor), prototipo basado en el concepto Tokamak, y en el que se espera alcanzar la ignición. Ante los buenos resultados obtenidos en el JET, en 1990 se decidió continuar el programa de fusión con una instalación mayor en la que además del reactor, pudieran probarse sus sistemas auxiliares sin generar aún electricidad. En este proyecto participan la Unión Europea, Canadá, EEUU, Japón y Rusia.

El objetivo es determinar la viabilidad técnica y económica de la fusión nuclear por confinamiento magnético para la generación de energía eléctrica, como fase previa a la construcción de una instalación de demostración comercial.

ITER es un proyecto tecnológico cuya construcción se estima necesitará 10 años y al menos 20 de investigación. Entre las tecnologías empleadas para su construcción y posterior funcionamiento y mantenimiento destacan la robótica, superconductividad, microondas, aceleradores y los sistemas de control.

En la máquina ITER no se producirá energía eléctrica, se probaran las soluciones a los problemas que necesitan ser resueltos para hacer viables los futuros reactores de fusión nuclear. Este ambicioso proyecto de investigación dará sus primeros resultados a partir de 2050.

Las inversiones realizadas para su construcción se estiman en cerca de 5.000 millones de euros. Los costes de funcionamiento alcanzarán los 5.300 millones de euros y los de desmantelamiento ascienden a 430 millones de euros. El país donde se instala (Francia) debe correr con los costes de preparación del terreno y de construcción del edificio.

Emplazamiento del ITER

En un principio, los tres emplazamientos que se disputaban el proyecto eran: Europa (Francia y España), Canadá y Japón.

El Gobierno Canadiense mostró interés por albergar el proyecto en Darlington cerca de Toronto, Japón presentó su candidatura en Rokkaishomura, Francia ofreció su centro nuclear de Cadarache y España propuso su emplazamiento en Vandellós I, después del positivo estudio de viabilidad coordinado por el CIEMAT y realizado por diferentes institutos de investigación e industrias, entre las que destaca IBERTEF (consorcio formado por EmpresariosAgrupados y SENER).

Después de un complejo proceso de evaluación tecnológica, a finales de 2003 la Comisión Europea decidió presentar como candidatura europea la francesa de Cadarache frente a la española de Vandellós.

Finalmente la candidatura ganadora fue la del sur de Francia que es donde se está construyendo en la actualidad.

Emplazamiento del ITER - fusión nuclear